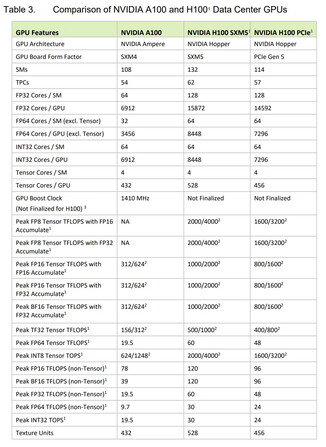

As GPUs Hopper H100 AI e HPC da Nvidia acabam de ser reveladas na GTC juntamente com os superchips Grace. Como sempre, os modelos de GPU de computação são altamente escaláveis, e a Nvidia oferece várias soluções multi-GPU para atender a diferentes necessidades de data center. Uma única GPU Tensor Core H100, por outro lado, vem com melhorias significativas em relação à 2020 Ampere A100 modelos, especialmente no departamento de operações FP.

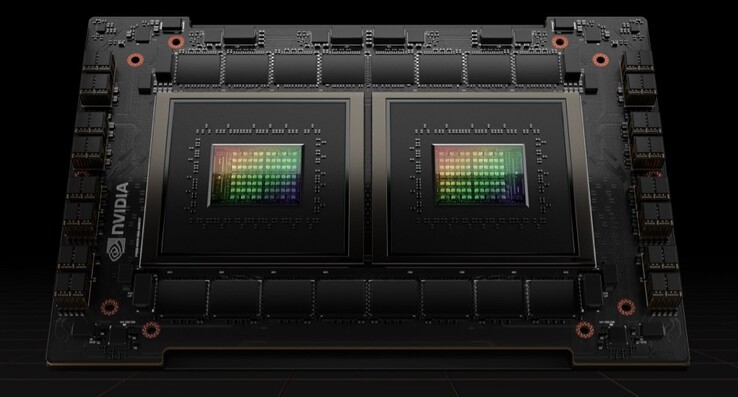

Primeiro de tudo, a GPU H100 é fabricada em Nós de 4 nm da TSMC e tem uma matriz de 814 mm² (14 mm² menor que a A100). Este modelo é o primeiro da Nvidia a apresentar PCIe 5.0 e há também um fator de forma SXM que é mais rápido. A GPU em si compreende nada menos que 80 bilhões de transistores, o que representa um aumento de quase 50% em relação ao Ampere. Também apresenta 132 clusters de GPU com 16896 núcleos CUDA para o padrão SXM e 14592 núcleos CUDA para o padrão PCIe 5.0, mais do que duplicando a contagem da geração anterior

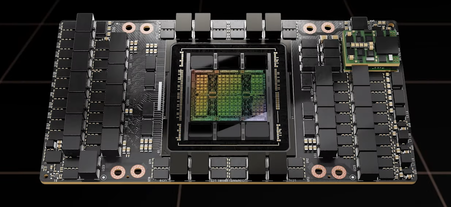

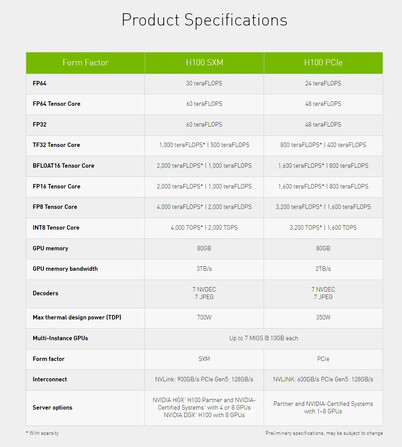

O cache L2 é aumentado de 40 MB para 50 MB, mas o barramento de memória permanece o mesmo em 5120 bits, e a capacidade de memória é ajustada para 80 GB HBM3 com 3 ou 2 TB/s de largura de banda, dependendo do fator de forma. A versão SXM possui 528 núcleos Tensor e requer 700 W, enquanto a versão PCIe possui apenas 456 núcleos Tensor e é limitada a 350 W TGP. A Nvidia afirma que as GPUs 20x H100 podem sustentar o equivalente ao tráfego de Internet do mundo inteiro, mas a nova arquitetura pode ser ampliada para centenas e até milhares de clusters DGX que serão usados em futuros supercomputadores

No que diz respeito ao desempenho de FP, a GPU H100 pode processar 4 PFLOPS de FP8 (6x sobre A100), 2 PFLOPS de FP16 (3x sobre A100), 1 PFLOPS de TF32 (3x sobre A100) e 60 TFLOPS de FP64/FP32 (3x sobre A100). Melhorias similares podem ser obtidas com os cálculos do Tensor Core FP.

Nvidia também está planejando liberar um Graça Módulo superchip Hopper que combina uma GPU H100 e uma CPU Grace conectada com um NVLink de 900 GB/s. Da mesma forma, haverá também um superchip Grace que combina duas CPUs Grace que oferecem 144 núcleos ARM, 1 TB/s LPDDR5x largura de banda de memória e 396 MB de cache on-chip. Este superchip Grace pode ser emparelhado com até oito GPUs Hopper, mas tais configurações não estarão disponíveis mais cedo do que o Q3 2023. As GPUs Hopper da Nvidia, no entanto, começarão a ser enviadas no terceiro trimestre de 2022.

Comprar o Nvidia Tesla v100 16GB GPU computadorizado na Amazon

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros