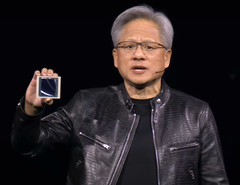

O CEO da Nvidia, Huang, revela os mais recentes produtos de IA para empresas, juntamente com os avanços nos recursos de veículos autônomos e robôs humanoides durante a palestra do GTC 2024

Nvidia O CEO Jensen Huang revelou os mais recentes produtos e serviços de IA da empresa durante a apresentação em GTC 2024 em 18 de março de 2024, em San Jose, CA. Voltadas para clientes corporativos, as novas ofertas da Nvidia prometem acelerar muito o aprendizado e a aplicação de IA em muitos campos, como robótica, previsão do tempo, descoberta de medicamentos e automação de armazéns. A GPU Blackwell da Nvidia, os NIMs, o NEMO e a fundição de IA estavam entre as ofertas notáveis apresentadas.

O processo de treinamento de IA é muito mais intensivo em termos de computação do que o uso de um modelo de IA, pois milhões de documentos de entrada devem ser processados. Isso pode levar semanas e até meses nos supercomputadores mais rápidos disponíveis atualmente para empresas como a Microsoft. A Nvidia lançou anteriormente a plataforma de GPU Hopper em 2022 para lidar com essas grandes cargas de computação.

Na GTC 2024, Huang revelou a Blackwell como a continuação da Hopper e está disponível em uma substituição de placa drop-in para as instalações atuais da Hopper. A GPU Blackwell consiste em duas matrizes de GPU com 104 bilhões de transistores em um processo TSMC 4NP (provavelmente N4P, erro de digitação na apresentação) para 20 FP4 petaflops com 192 GB de memória HBM3e capaz de transferir 8 TB/s. Em comparação, um desktop gPU 4090 para desktop tem uma única GPU com 76,3 bilhões de transistores, processo 5NM, com desempenho de até 1,32 Tensor FP8 petaflops com 24 GB de memória GDDR6X. Se o senhor dobrar o número FP8 do 4090 para ajustá-lo a 4 bits, serão aproximadamente 20 petaflops Blackwell contra 3 petaflops 4090.

Quando 72 GPUs Blackwell são colocadas em um único gabinete DGX GB200 NVL72 juntamente com resfriamento líquido, CPUs NVLink aprimoradase outras melhorias na interconexão, o desempenho em relação aos gabinetes Hopper aumenta 22 vezes para o treinamento de IA FP8 e 45 vezes para a inferência de IA FP4. O consumo de energia do treinamento de IA da Blackwell também foi reduzido em aproximadamente 4 vezes em relação ao Hopper.

Modelos de IA pré-embalados do NIMS

Para aproveitar esse salto no desempenho, a Nvidia introduziu modelos de IA pré-embalados chamados NIMS (Nvidia Inference Microservice)utilizando o Kubernetes para execução em GPUs CUDA da Nvidia localmente ou na nuvem. O acesso ao NIMS autônomo é feito por meio de uma API HUMANA simplificada. O objetivo por trás disso é criar um futuro em que os serviços de IA sejam criados solicitando a uma IA que crie um aplicativo com determinados recursos e, em seguida, a IA misture e combine vários NIMS sem precisar de programação de baixo nível. Finalmente, para ajudar no treinamento de NIMS, a Nvidia apresentou o NeMO Microservices para personalizar, avaliar e proteger o processo de treinamento em documentos corporativos.

Nvidia BioNeMO e NIMS biológicos

Huang anunciou que a Nvidia desenvolverá NIMS treinado em dados biológicos e médicos para fornecer aos pesquisadores acesso mais fácil à IA que pode melhorar todos os aspectos da medicina, como encontrar candidatos a medicamentos mais rapidamente.

Thor ASIL-D e veículos EV autônomos da BYD

De forma significativa, Huang afirmou que BYD será a primeira montadora de veículos elétricos do mundo a adotar seu novo computador Thor ASIL-D que utiliza um SoC de IA para processar informações visuais e de direção para proporcionar alta segurança na direção autônoma. Juntamente com o recente anúncio do SuperDrive by Plusisso sugere que a BYD será uma das primeiras empresas automobilísticas a lançar um veículo EV autônomo de nível 4 https://www.sae.org/blog/sae-j3016-update veículo EV autônomo.

Nvidia Project Groot robôs humanoides

Huang demonstrou ainda mais seus avanços em robótica, apresentando as habilidades de seus robôs, que primeiro são treinados no Omniverse como um gêmeo digital e, em seguida, são autorizados a realizar tarefas em corpos robóticos reais. Foram mostradas atividades de assar, girar palitos com os dedos, classificar e montar produtos e contornar obstáculos. Para atingir esse nível de robótica, o Nvidia Project Groot Foi criada treinando-a primeiramente com entradas de texto, vídeo e demonstração e, em seguida, refinada com observações reais de tarefas sendo realizadas. Juntamente com o mesmo computador Thor usado nos veículos e com o modelo de linguagem Nvidia Tokkio AI modelo de linguagem, os robôs de demonstração puderam observar as ações realizadas por humanos e, em seguida, replicá-las para preparar bebidas, tocar bateria e responder a solicitações faladas.

O Nvidia Omniverse Cloud adiciona suporte ao Apple Vision Pro

De menor importância, Huang afirmou que o Nvidia Omniverse Cloud agora transmite para o Apple Vision Pro além do fone de ouvido Meta Quest e HTC Vive Proa placa de vídeo Nvidia Vision Pro, claramente para desenvolvedores que estão utilizando GPUs de nuvem da Nvidia, já que nenhum Macintosh tem uma GPU Nvidia compatível.

Os leitores que quiserem participar da revolução da IA precisarão de uma poderosa placa de vídeo Nvidia(como esta da Amazon) para desenvolver habilidades e aplicativos de IA.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

NVIDIA lança DGX SuperPOD com Blackwell para supercomputação de AI generativa em escala de trilhões de parâmetros

Escala para dezenas de milhares de Grace Blackwell Superchips usando a rede mais avançada da NVIDIA, o software de AI de pilha completa da NVIDIA e recursos de armazenamento de até 576 GPUs Blackwell conectadas como uma só com o NVIDIA NVLink Os especialistas em sistemas da NVIDIA aceleram a implantação da infraestrutura de AI imediata

18 de março de 2024

a GTC-NVIDIA anunciou hoje seu supercomputador de AI de última geração - o NVIDIA DGX SuperPOD™ equipado com NVIDIA GB200 Grace Blackwell Superchips - para processar modelos de trilhões de parâmetros com tempo de atividade constante para treinamento de AI generativo em superescala e cargas de trabalho de inferência.

Apresentando uma nova arquitetura em escala de rack altamente eficiente e com refrigeração líquida, o novo DGX SuperPOD é construído com os sistemas NVIDIA DGX™ GB200 e fornece 11,5 exaflops de supercomputação de AI com precisão FP4 e 240 terabytes de memória rápida - escalonando para mais com racks adicionais.

Cada sistema DGX GB200 apresenta 36 superchips NVIDIA GB200 - que incluem 36 CPUs NVIDIA Grace e 72 GPUs NVIDIA Blackwell - conectados como um supercomputador por meio do NVIDIA NVLink® de quinta geração. Os superchips GB200 oferecem um aumento de desempenho de até 30 vezes em comparação com a GPU NVIDIA H100 Tensor Core para grandes cargas de trabalho de inferência de modelos de linguagem.

"Os supercomputadores NVIDIA DGX AI são as fábricas da revolução industrial da AI", disse Jensen Huang, fundador e CEO da NVIDIA. "O novo DGX SuperPOD combina os mais recentes avanços em computação acelerada, rede e software da NVIDIA para permitir que todas as empresas, indústrias e países refinem e gerem sua própria IA"

O DGX SuperPOD com tecnologia Grace Blackwell apresenta oito ou mais sistemas DGX GB200 e pode ser dimensionado para dezenas de milhares de Superchips GB200 conectados via NVIDIA Quantum InfiniBand. Para obter um enorme espaço de memória compartilhada para alimentar modelos de AI de última geração, os clientes podem implementar uma configuração que conecta as 576 GPUs Blackwell em oito sistemas DGX GB200 conectados via NVLink.

Nova arquitetura DGX SuperPOD em escala de rack para a era da IA generativa

O novo DGX SuperPOD com sistemas DGX GB200 apresenta uma malha de computação unificada. Além do NVIDIA NVLink de quinta geração, a malha inclui DPUs NVIDIA BlueField®-3 e será compatível com a rede NVIDIA Quantum-X800 InfiniBand, anunciada separadamente hoje. Essa arquitetura fornece até 1.800 gigabytes por segundo de largura de banda para cada GPU na plataforma.

Além disso, a tecnologia NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ de quarta geração fornece 14,4 teraflops de computação em rede, um aumento de 4x na arquitetura DGX SuperPOD de última geração em comparação com a geração anterior.

Arquitetura turnkey emparelhada com software avançado para um tempo de atividade sem precedentes

O novo DGX SuperPOD é um supercomputador de AI completo, em escala de data center, que se integra ao armazenamento de alto desempenho de parceiros certificados pela NVIDIA para atender às demandas de cargas de trabalho de AI generativas. Cada um é construído, cabeado e testado na fábrica para acelerar drasticamente a implantação nos data centers dos clientes.

O DGX SuperPOD com tecnologia Grace Blackwell apresenta recursos inteligentes de gerenciamento preditivo para monitorar continuamente milhares de pontos de dados em hardware e software para prever e interceptar fontes de tempo de inatividade e ineficiência - economizando tempo, energia e custos de computação.

O software pode identificar áreas de preocupação e planejar a manutenção, ajustar com flexibilidade os recursos de computação e salvar e retomar automaticamente os trabalhos para evitar tempo de inatividade, mesmo sem a presença de administradores de sistema.

Se o software detectar a necessidade de substituição de um componente, o cluster ativará a capacidade de espera para garantir que o trabalho seja concluído a tempo. Qualquer substituição de hardware necessária pode ser programada para evitar tempo de inatividade não planejado.

Sistemas NVIDIA DGX B200 avançam na supercomputação de IA para setores

A NVIDIA também apresentou o sistema NVIDIA DGX B200, uma plataforma unificada de supercomputação de IA para treinamento, ajuste fino e inferência de modelos de IA.

O DGX B200 é a sexta geração de projetos DGX refrigerados a ar e montados em rack tradicionais usados por indústrias em todo o mundo. O novo sistema DGX B200 de arquitetura Blackwell inclui oito GPUs NVIDIA Blackwell e dois processadores Intel® Xeon® de 5ª geração. Os clientes também podem construir o DGX SuperPOD usando sistemas DGX B200 para criar Centros de Excelência em IA que podem potencializar o trabalho de grandes equipes de desenvolvedores que executam muitos trabalhos diferentes.

Os sistemas DGX B200 incluem o recurso de precisão FP4 na nova arquitetura Blackwell, fornecendo até 144 petaflops de desempenho de IA, um enorme 1,4 TB de memória de GPU e 64 TB/s de largura de banda de memória. Isso proporciona uma inferência em tempo real 15 vezes mais rápida para modelos de trilhões de parâmetros em relação à geração anterior.

Os sistemas DGX B200 incluem redes avançadas com oito NICs NVIDIA ConnectX™-7 e duas DPUs BlueField-3. Elas fornecem até 400 gigabits por segundo de largura de banda por conexão, proporcionando rápido desempenho de IA com as plataformas de rede NVIDIA Quantum-2 InfiniBand e NVIDIA Spectrum™-X Ethernet.

Software e suporte especializado para escalar a produção de AI

Todas as plataformas NVIDIA DGX incluem o software NVIDIA AI Enterprise para desenvolvimento e implantação de nível empresarial. Os clientes da DGX podem acelerar seu trabalho com os modelos de base, frameworks, kits de ferramentas e novos microsserviços NVIDIA NIM pré-treinados incluídos na plataforma de software.

Os especialistas em NVIDIA DGX e os parceiros selecionados da NVIDIA certificados para oferecer suporte às plataformas DGX auxiliam os clientes em todas as etapas da implantação, para que eles possam mover rapidamente a AI para a produção. Depois que os sistemas estiverem operacionais, os especialistas em DGX continuarão a dar suporte aos clientes na otimização de seus pipelines e infraestrutura de AI.

Disponibilidade

Espera-se que o NVIDIA DGX SuperPOD com sistemas DGX GB200 e DGX B200 esteja disponível ainda este ano nos parceiros globais da NVIDIA.

Para obter mais informações, assista a um replay da palestra da GTC ou visite o estande da NVIDIA na GTC, realizada no Centro de Convenções de San Jose até 21 de março.