A OpenAI anunciou o lançamento do gpt-oss-120b e do gpt-oss-20b, dois modelos de peso aberto que são gratuitos para download e podem ser executados localmente em seu sistema. É o primeiro lançamento de código aberto da empresa desde o lançamento do GPT-2 em 2019.

O Gpt-oss-120b é o modelo de 117 bilhões de parâmetros que requer 80 GB de VRAM para ser executado. O menor gpt-oss-20b, o modelo de 21 bilhões de parâmetros, pode caber em uma única GPU com 16 GB de VRAM. Ambos os modelos estão disponíveis sob uma licença Apache 2.0 flexível.

A OpenAI diz que o "lançamento é um passo significativo em seu compromisso com o ecossistema de código aberto, em linha com sua missão declarada de tornar os benefícios da IA amplamente acessíveis" A empresa quer que eles sirvam como uma ferramenta de baixo custo para desenvolvedores, pesquisadores e empresas executarem e personalizarem com eficiência.

Qual é o desempenho deles?

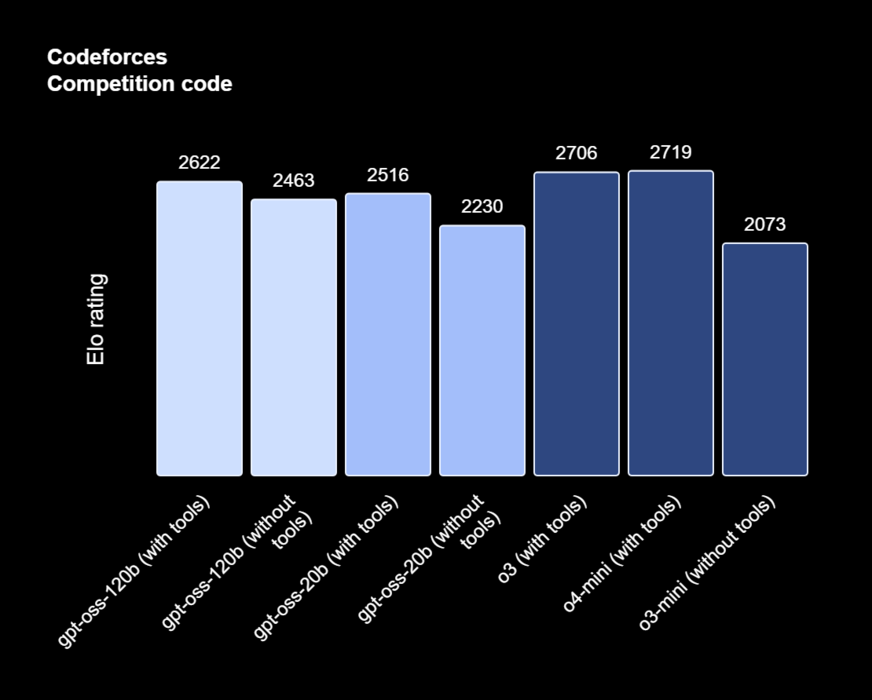

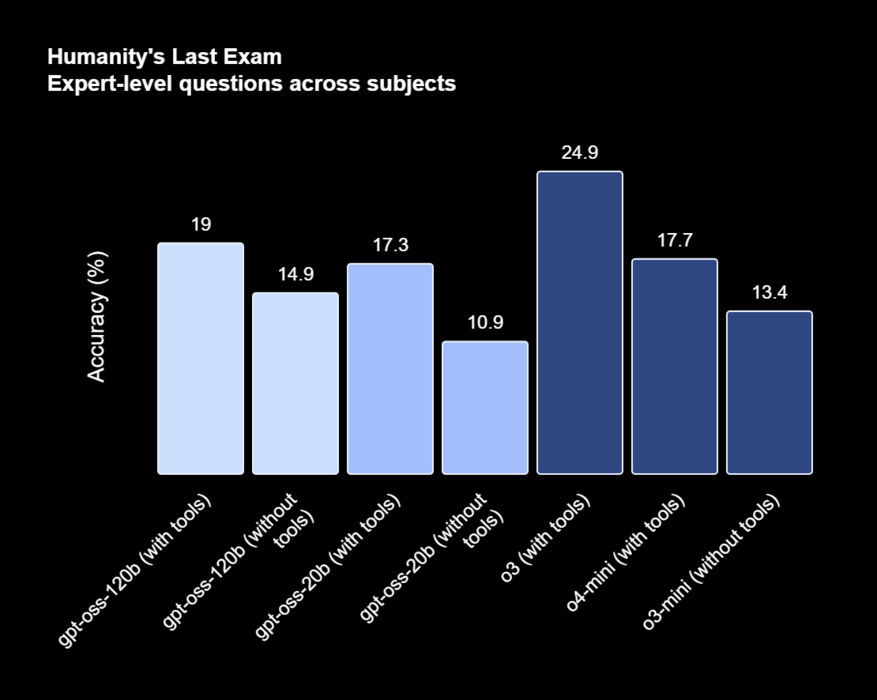

O gpt-oss-120b marcou 2.622 pontos no teste de codificação do Codeforces com ferramentas, com desempenho quase igual ao do o3 e do o4-mini da empresa, e superou confortavelmente o o3-mini em ambos os testes, marcando 2.643 pontos sem ferramentas.

O gpt-oss-20b obteve 2516 pontos com ferramentas, com desempenho equivalente ao do com o3 e o4-mini, e 2230 sem ferramentas, superando por pouco o o3-mini. A OpenAI diz que o 120b se sai ainda melhor em consultas relacionadas à saúde e matemática do que o o4-mini, enquanto o 20b supera o o3-mini.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

A OpenAI afirma que tanto o 120b quanto o 20b tendem a alucinar muito mais do que modelos de raciocínio como o3 e o4-mini. Em testes, eles descobriram que ambos os modelos de peso aberto alucinaram de 49% a 53% em seus benchmarks internos que testam os modelos em seu conhecimento sobre as pessoas.

Ambos os modelos podem ser baixados do espaço oficial do Hugging Face e vêm nativamente quantizados em MXFP4 para maior eficiência. Eles também podem ser implantados livremente em plataformas como Microsoft Azure, Hugging Face, vLLM, Ollama e llama.cpp, LM Studio, AWS, Fireworks, Together AI e muito mais.

A OpenAI espera que esses modelos "reduzam as barreiras para mercados emergentes, setores com recursos limitados e organizações menores que podem não ter o orçamento ou a flexibilidade para adotar modelos proprietários"

Quanto ao motivo pelo qual eles abriram um novo modelo seis anos após o último, a empresa diz que quer "tornar a IA amplamente acessível e benéfica para todos"