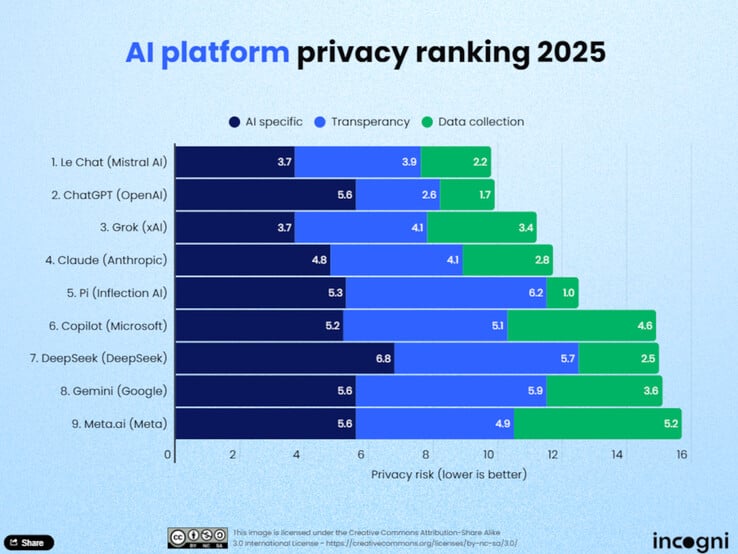

O uso da inteligência artificial (IA) na vida cotidiana está aumentando e, com isso, a importância da proteção de dados. Os analistas de proteção de dados da Incogni avaliaram recentemente nove dos principais modelos de linguagem ampla (LLMs) para determinar quais plataformas respeitam mais a privacidade do usuário. O estudo avalia os modelos de IA com base em onze critérios divididos em três categorias principais: coleta de dados para treinamento, transparência e uso e compartilhamento de dados.

Melhores classificações

O Le Chat da Mistral AI lidera o ranking. De acordo com a Incogni, o modelo coleta comparativamente poucos dados de usuários e oferece uma abordagem muito eficiente em termos de dados, tanto durante a fase de treinamento quanto na operação ao vivo. Logo atrás vem o ChatGPT da OpenAI, que ganha pontos principalmente por sua transparência. Os usuários podem especificar especificamente em suas contas se seus bate-papos podem ser usados para desenvolver ainda mais o modelo e, se o histórico for desativado, o armazenamento será impedido. O Grok da xAI ocupa o terceiro lugar, também impressionando por suas práticas transparentes de proteção de dados.

Último na classificação

Na parte inferior da classificação estão o Meta AI, o Gemini do Google e o Copilot da Microsoft. De acordo com a Incogni, essas plataformas coletam muitos dados sem oferecer aos usuários opções claras de cancelamento. O DeepSeek, um modelo chinês, também tem um desempenho ruim. Esses provedores não oferecem opções claras para excluir os dados do usuário do treinamento.

Metodologia

Os analistas da Incogni avaliaram as plataformas com base em onze critérios divididos em três categorias: coleta de dados para treinamento, transparência e uso e compartilhamento de dados. A categoria "uso e compartilhamento de dados" foi responsável por 50% da classificação geral, enquanto "transparência" foi responsável por 30% e "dados de treinamento" por 20%. Apenas quatro das nove ferramentas testadas permitem que os usuários excluam ativamente seus dados do treinamento.

Conclusão

O estudo mostra que a proteção de dados ainda não é padrão em todo o mundo da IA. Portanto, os usuários devem se familiarizar ativamente com as políticas de privacidade dos provedores, especialmente quando se trata de conteúdo sensível, informações confidenciais de clientes ou dados pessoais. Aqueles que valorizam a proteção de dados encontrarão opções razoáveis no Le Chat, ChatGPT ou Grok. No entanto, os LLMs realmente eficientes em termos de dados ainda serão a exceção em 2025

Fonte(s)

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros