Samsung envia a memória de IA mais cara que a Nvidia já encomendou, pois o HBM4 excede as principais especificações

A Samsung anunciou as primeiras remessas comerciais de uma memória HBM4 de última geração para aplicativos como GPUs da Nvidia e os respectivos data centers de IA.

A Nvidia e outros clientes estão supostamente pagando cerca de US$ 500 cada para a Samsung, o dobro do que costumavam pagar pela geração anterior de memória de alta largura de banda HBM3E. Como consequência, as ações da Samsung estão em alta, e sua gerência espera outro ano de sucesso de bilheteria, aproveitando a escassez geral de memória falta de memória.

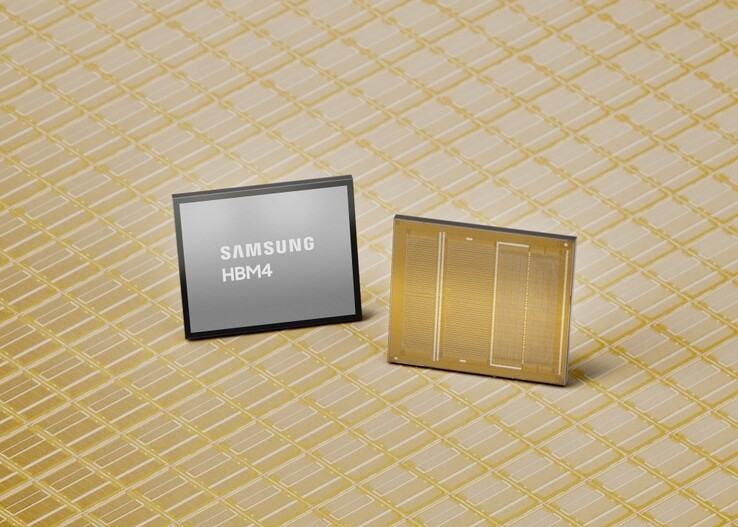

Especificações da memória HBM4 da Samsung

Enquanto os fabricantes de memória estão cobrando caro por qualquer unidade que produzem, a Samsung afirma que sua nova memória HBM4 AI conseguiu superar o padrão Joint Electron Device Engineering Council (JEDEC) e os requisitos da Nvidia.

A velocidade de operação do HBM4 pode chegar a incríveis 13 Gbps, ou 46% acima dos requisitos do JEDEC, e sua largura de banda total de memória é de até 3,3 TB/s por pilha, excedendo em muito a exigência de 3 TB/s de clientes como a Nvidia.

A Samsung alcançou essa taxa de transferência vertiginosa aplicando preventivamente o processo DRAM 1c de 6ª geração da classe 10nm com a matriz de base fabricada a 4nm, em oposição à DRAM 1a de 14nm usada para o antecessor HBM3. Isso dá à geração de memória HBM4 AI muito espaço para melhorias no processo e no desempenho. Para gerenciar todo o calor gerado, a Samsung projetou o núcleo e a transmissão de dados com tecnologias de baixa potência e baixa tensão para uma dissipação de calor 30% melhor e uma eficiência energética 40% maior em comparação com a geração de memória HBM3 que a Nvidia está usando agora em suas placas de vídeo AI na série Blackwell.

Por enquanto, a Samsung pode enviar aos clientes um máximo de 36 GB de capacidade de memória HBM4 por meio de uma pilha de 12 camadas, mas também pode criar um empilhamento de 16 camadas para um total de 48 GB quando a Nvidia estiver pronta com o respectivo design de GPU e poder de compra. A Samsung promete o suficiente dos caros chips HBM4, dizendo que"continuará a garantir recursos de fornecimento estáveis para atender à crescente demanda de médio e longo prazo, particularmente de IA e data centers", à medida que começa a testar sua memória HBM4E de próxima geração no segundo semestre de 2026.

Obtenha o kit de memória para laptop Crucial DDR5 de 64 GB na Amazon

Fonte(s)

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros