A Microsoft lançou o Phi-3 no início desta semana no HuggingFace, Ollama e no catálogo do Azure AI. Embora ele não corresponda exatamente às habilidades de conhecimento geral do Windows Copilota tecnologia de IA de código aberto representa a quarta geração de pequenos modelos de linguagem de Redmond que rivalizam com os LLMs convencionais em termos de velocidade, eficiência e desempenho.

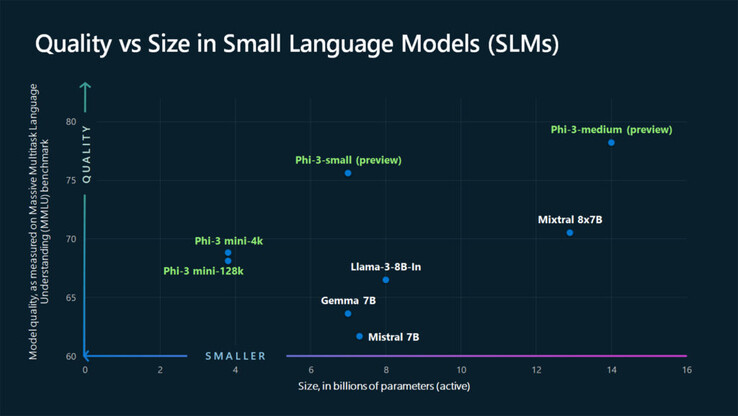

Com 3,8 bilhões de parâmetros, o Phi-3 é um pouco maior do que o seu antecessor mas continua pequeno o suficiente para ser executado em apenas 1,8 GB de armazenamento móvel. Para efeito de comparação, um LLM complexo típico, como o Llama ou o GPT-3.5, utiliza centenas de bilhões de parâmetros para compreender a entrada e é impraticável armazenar nativamente. GPT-5, que será lançado neste verãoespera-se que tenha um tamanho de trilhões de parâmetros. Pelas leis de escalonamento convencionais, mais parâmetros significam resultados mais inteligentes. Mas, de acordo com a Microsoft, esse pode não ser necessariamente o caso.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

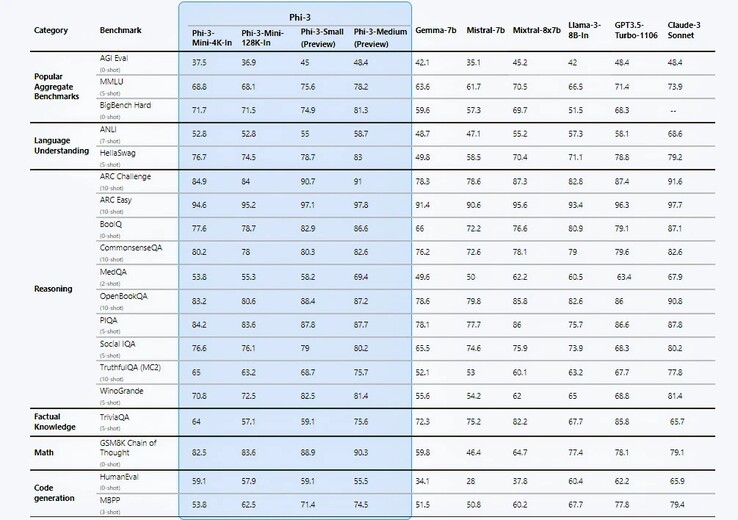

A Microsoft faz algumas afirmações ousadas em seu relatório técnico https://arxiv.org/pdf/2404.14219sendo a principal delas os benchmarks de desempenho que, segundo a própria empresa, são puramente acadêmicos. Em 12 dos 19 testes de benchmark, o Phi-3-mini parece superar o Llama-3-instruct, apesar de ser executado com mais do que o dobro de parâmetros. Com o Phi-3-small de 7B e o Phi-3-medium de 14B, os resultados foram ainda mais surpreendentes.

Os engenheiros atribuem esses ganhos de eficiência ao seu conjunto de dados de treinamento cuidadosamente selecionado cuidadosamente selecionado, derivado de duas fontes: conteúdo da Web com "qualidade de livro-texto" e dados gerados por IA projetados para ensinar linguagem, conhecimento geral e raciocínio de senso comum com uma lista selecionada de 3.000 palavras que servem como blocos de construção. Os pesquisadores da Microsoft afirmam que esse tipo de receita de dados permitiu que o Phi-2 do ano passado igualasse o desempenho do modelo Llama-2 da Meta, consideravelmente maior (70 B) Modelo Llama-2 da Meta.

Eric Boyd, vice-presidente corporativo do Azure AI, se vangloria através do The Verge de que o Phi-3 é tão capaz quanto o GPT-3.5, embora em um "fator de forma menor". No entanto, o Phi-3 continua a ser afetado por uma deficiência no conhecimento factual devido ao seu tamanho limitado. Será que essa é uma compensação necessária para que a IA seja executada nativamente em vez de por meio da computação em nuvem?

Considerando que a flexibilidade e o custo-benefício são questões fundamentais para as empresas, não é de surpreender que as empresas já tenham começado a aproveitar os recursos dos SLMs. No entanto, o Phi-3 tem uma concorrência acirrada. O Meta's Llama-3da Anthropic, Claude-3 suitedo Google Gemini e Gemma todos têm versões leves que são capazes de suportar a computação de ponta em dispositivos móveis. E embora o Phi-3 pareça competir favoravelmente, o Gemini Nano já chegou a dispositivos como o Google Pixel 8 Pro e o Samsung Galaxy S24 series(US$ 784 na Amazon).

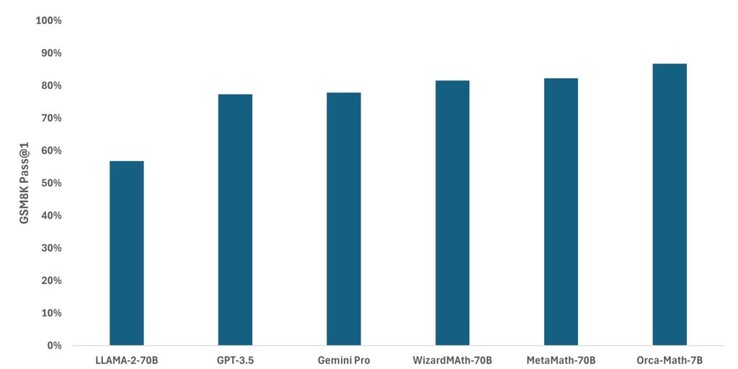

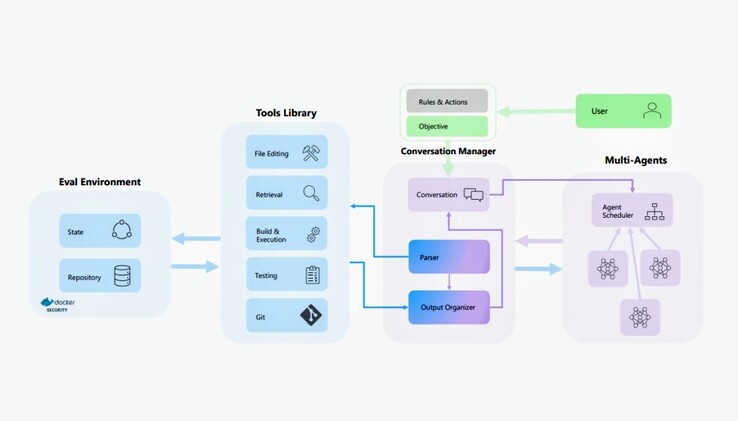

A família Phi-3 de modelos de IA não é, de forma alguma, o único SLM em que a Microsoft está trabalhando. No mês passado, a empresa adaptou o Mistral para criar o Orca-Mathum modelo especializado que demonstrou ser consideravelmente mais preciso do que o Llama, o GPT-3.5 e o Gemini Pro em matemática do ensino fundamental. AutoDevum projeto mais recente, baseia-se no AutoGen e no Auto-GPT para planejar e executar autonomamente tarefas de programação com base em objetivos definidos pelo usuário. A guerra da IA está longe de terminar, mas, pelo menos na escala mais baixa, temos um concorrente de peso.

![A Microsoft quer saber se o(a) senhor(a) consideraria adquirir um novo dispositivo portátil para jogos nos próximos cinco anos (Fonte da imagem: Logitech [editado])](fileadmin/_processed_/a/0/csm_Logitech-G-Cloud_f62f43f9e7.jpg)