Análise da estação HP ZGX Nano G1n AI: Potência de servidor compacta com Nvidia DGX Spark

Pequeno, preto e caro.

A HP ZGX Nano G1n AI Station tem como objetivo ser o ponto de entrada perfeito para desenvolvedores de IA. Com 128 GB de RAM e tecnologia Nvidia a bordo, ele promete potência de servidor para uso. No entanto, o ecossistema DGX Spark da Nvidia é apenas parcialmente convincente.Marc Herter (traduzido por DeepL / Ninh Duy) Publicado 🇺🇸 🇩🇪 ...

Veredicto - Entrada no ecossistema de IA

A HP ZGX Nano G1n AI Station demonstra seus pontos fortes principalmente no campo dos aplicativos profissionais especializados. Seu maior trunfo é, sem dúvida, a arquitetura Blackwell. Com suporte para o novo formato de dados FP4 e os modelos NVFP4 e NVFP8 otimizados pela Nvidia, os aplicativos de IA podem ser executados mais rapidamente e ocupar significativamente menos VRAM. Essa é uma vantagem tecnológica atualmente encontrada apenas na Nvidia. Além disso, esse gadget concede acesso ao ecossistema DGX da Nvidia, o que facilita o escalonamento de pequenos experimentos até clusters de servidores maciços. Os desenvolvedores com uma sólida compreensão da pilha de software da Nvidia acharão essa "ponte para o data center" inestimável. É impressionante a capacidade de IA possível em um espaço tão pequeno.

No entanto, o alto preço de cerca de 4.000 euros gera expectativas que o dispositivo não consegue atender em termos de tato e ergonomia. O chassi de plástico parece básico demais para essa faixa de preço, e a ventoinha permanentemente audível, bem como o alto consumo de energia de até 50 watts no modo ocioso, mancham a impressão no uso diário. Gostaríamos de ter tido mais refinamento aqui, especialmente porque o dispositivo geralmente fica diretamente sobre uma mesa. Afinal de contas, esse dispositivo é destinado àqueles que realmente querem trabalhar com inteligência artificial.

A Team Red, por outro lado, é uma forte concorrente se tudo o que o senhor deseja é uma grande quantidade de memória local para executar grandes modelos de IA e não precisa dos recursos que a Nvidia oferece. Os sistemas baseados na plataforma AMD Strix Halo, como o Bosgame M5 AI Mini Desktope o Framework Desktopou o GMKtec EVO-X2 com o Ryzen AI Max+ 395, oferecem configurações de memória generosas e desempenho sólido em muitos aplicativos de IA padrão - a um preço significativamente mais atraente. No entanto, a estação HP continua sendo a primeira opção para os especialistas da Nvidia.

Pro

Contra

Preço e disponibilidade

Há grandes diferenças de preço para a HP ZGX Nano G1n AI Station. O modelo de 4 TB está atualmente listado na Amazon por US$ 4.759,00, enquanto a HP Store cobra US$ 7.399,00.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

HP ZGX Nano G1n AI Station é um nome bastante longo para o que é realmente a plataforma de referência DGX Spark da Nvidia. Concorrentes como Gigabyte, Asus, Acer e Dell fornecem kits para desenvolvedores de IA, portanto, a HP não é a única a usar essa estratégia. As diferenças geralmente estão nos detalhes, como pequenos ajustes na pilha de software ou no design do chassi. O conceito em si demonstra ser extremamente flexível: A caixa compacta pode ser operada como um servidor dedicado "sem cabeça" na rede ou - graças às portas disponíveis - como uma estação de trabalho completa com mouse, teclado e monitor diretamente na mesa. Usamos o Crowview Note confortavelmente para essa finalidade em nosso teste. Foi dada atenção especial à facilidade de configuração. A Nvidia e a HP querem tornar a entrada no desenvolvimento local de IA o mais simples possível e incluem projetos prontos, os chamados Blueprints, que saem da caixa.

Especificações

| Especificações | Estação de IA HP ZGX Nano G1n |

| Processador (SoC com chip gráfico) | NVIDIA GB10 Grace Blackwell Superchip (20 núcleos: 10x Cortex-X925 + 10x Cortex-A725) NVIDIA Blackwell GPU (integrada, até 1.000 TOPS em FP4) |

| Memória | Memória unificada LPDDR5x de 128 GB (largura de banda de 273 GB/s, soldada) |

| Armazenamento | 1 TB ou 4 TB M.2 2242 NVMe SSD (PCIe Gen4) |

| Portas | 3x USB-C 3.2 (20 Gbit/s), 1x HDMI 2.1a, 1x Ethernet de 10 Gbit, 2x QSFP (interconexão de 200 Gbit/s) |

| Rede | Wi-Fi 7 (MediaTek MT7925), Bluetooth 5.4 |

| Dimensões | 150 x 150 x 51 mm (L x P x A) |

| Peso | 1,25 kg |

| Fonte de alimentação | 240 Watt USB-C (externo) |

| SO | NVIDIA DGX OS (baseado no Ubuntu Linux) |

| Preço | a partir de aproximadamente 3.605 euros (preço de mercado) |

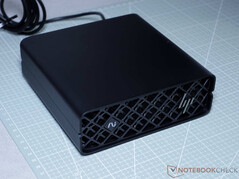

Case e conectividade - pequeno e simples

A HP ZGX Nano G1n AI Station apresenta um formato extremamente compacto com dimensões de aproximadamente 15 × 15 × 5,5 cm e um peso de apenas 1,25 kg. Isso facilita a acomodação em qualquer mesa. A seção frontal é atraente e consiste quase inteiramente em um design de grade diferenciado para garantir o fluxo de ar ideal para os potentes componentes internos. O logotipo da HP e um discreto logotipo "AI" estão integrados aqui.

A HP enfatiza a sustentabilidade com esse modelo. O AI Station contém até 40% de plástico reciclado, até 75% de alumínio reciclado e pelo menos 20% de aço reciclado. Além disso, a embalagem externa é feita de materiais 100% sustentáveis e recicláveis. Todo o exterior do AI Station é feito de plástico preto.

A seleção de portas é voltada para as necessidades profissionais. Na parte traseira, há uma porta Ethernet rápida de 10 Gbit, bem como duas portas QSFP para a interconexão de alta velocidade da Nvidia, permitindo o dimensionamento ao conectar várias unidades. Três portas USB-C estão disponíveis para periféricos. Uma saída HDMI 2.1 permite conectar um monitor ao console, mesmo que o dispositivo provavelmente seja usado com frequência no modo "sem cabeça". O sistema se comunica sem fio via Wi-Fi 7 e Bluetooth 5.4.

Desempenho - Especializado para IA, limitado por LPDDR5x

A peça central do ZGX Nano G1n é o chip GB10 da Nvidia, cujo perfil de desempenho é baseado aproximadamente em um Nvidia GeForce RTX 5070, embora com um foco significativamente diferente. A Nvidia otimizou consistentemente a arquitetura aqui para cargas de trabalho de IA, o que é perceptível em uma distribuição alterada de TMUs e núcleos Tensor em detrimento dos ROPs clássicos. Na prática, porém, as especificações de memória tornam esse chip potente mais lento. Enquanto uma RTX 5070 pode contar com 12 GB de VRAM com uma largura de banda de memória de 672,0 GB/s, a GB10 precisa se contentar com 273,2 GB/s.

A memória LPDDR5X de 128 GB instalada é, portanto, extremamente generosa em termos de capacidade, permitindo o carregamento e o processamento de LLMs maciços e modelos de IA que não encontrariam espaço em placas de consumo convencionais, mas se mostra comparativamente lenta. Dependendo do tamanho do modelo carregado ou da complexidade do contexto, esse gargalo restringe visivelmente o desempenho da IA. O mesmo fica evidente com modelos de texto para imagem como o SDXL. Em vários testes com o ComfyUI ou o JupyterLab, conseguimos cerca de três iterações por segundo (it/s) na geração de imagens. De acordo com nossa experiência, PCs bem equipados com uma RTX 5070 atingem 4,5 it/s.

Os núcleos ARM do módulo Grace oferecem excelente desempenho de vários núcleos, o que é ideal para tarefas paralelas. No entanto, em aplicativos que dependem muito do desempenho de um único núcleo, o desempenho bruto inferior dos núcleos individuais em comparação com as atuais CPUs x86 de ponta torna-se perceptível.

Uso prático - de brinquedo caro a supercomputador de IA

A HP ZGX Nano G1n AI Station se posiciona como uma plataforma de desenvolvimento que é muito mais do que apenas um brinquedo caro. Sua compatibilidade com a plataforma Nvidia DGX é o fator decisivo. Tudo o que foi desenvolvido ou testado na pequena estação pode ser dimensionado sem problemas para grandes servidores de IA. Isso torna o dispositivo excelente para prototipagem, ajuste fino de modelos, aplicativos de borda e ciência de dados, embora menos para inferência produtiva pura e em grande escala.

A Nvidia oferece vários "Blueprints" para diferentes casos de uso, mas a aplicação prática revela algumas armadilhas. Em nosso teste, nem todos os modelos funcionaram imediatamente; algumas instruções estavam desatualizadas e simplesmente inutilizáveis devido a versões mais recentes do software. Por exemplo, o "Multi-modal Inference" não pôde ser instalado em nosso teste.

O tempo de carregamento de grandes modelos de IA também pode ser desagradavelmente longo. Foram necessários até três minutos para que o sistema ficasse pronto ao iniciar o modelo GPT-OSS:120B. Depois que o modelo é carregado, no entanto, o processamento imediato é impressionantemente rápido, desde que o limite de contexto não seja excedido. Em nosso teste, a contagem do modelo foi de 1 a 1000, com os números escritos por extenso. Inicialmente, obtivemos um número impressionante de 40 a 55 tokens por segundo. Entretanto, como a memória de contexto se enche rapidamente durante a contagem, o desempenho caiu drasticamente em torno do número quinhentos, ficando abaixo do limite utilizável de 5 tokens por segundo.

Em resumo, o conceito do DGX Spark lembra mais uma minivan do que um carro esportivo: Há muito espaço para modelos grandes, mas não há velocidade máxima absoluta. Isso é prático em muitos cenários de desenvolvimento, mas não é necessariamente a melhor solução para aplicativos produtivos e de alto desempenho. No entanto, vale a pena manter as coisas em perspectiva. Se cada segundo não for importante durante a inferência, o HP ZGX Nano G1n AI Station e outras alternativas do DGX Spark podem ser uma solução significativamente mais econômica. Também é possível imaginar o uso de um DGX Spark em pequenos escritórios. Um modelo de linguagem de tamanho médio poderia atender de 10 a 20 funcionários simultaneamente sem causar atrasos desagradáveis.

Um SSD NVMe é instalado para armazenar os modelos grandes. Nossa unidade de análise vem equipada com um SSD PCIe 4 de 1 TB. Rapidamente, ele foi completamente preenchido com vários modelos de linguagem, modelos de geração de imagens e outros aplicativos. Embora a capacidade de armazenamento possa ser perfeitamente adequada para muitos casos de uso, tivemos que fazer malabarismos com dados e modelos de IA durante nossos testes. Entretanto, a sobretaxa para um SSD de 4 TB é de 800 euros, portanto, o investimento deve ser considerado com cuidado. Mesmo que o SSD possa ser trocado mais tarde, vale a pena dar uma olhada no mercado primeiro. Atualmente, só encontramos um SSD no formato apropriado da Corsair, ou seja, o MP700 MICRO 4 TB PCIe 5.0.

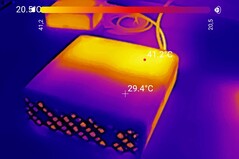

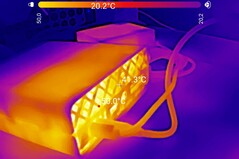

Emissões e energia - Consome muita energia mesmo quando está ocioso

A HP inclui uma poderosa fonte de alimentação USB-C de 240 watts com o AI Station, o que parece necessário, dado o apetite do dispositivo por energia. Com a utilização total da GPU, o consumo de energia sobe para 206 watts em nossas medições. Para cargas de trabalho típicas e sustentadas, como a inferência LLM, o consumo se estabiliza em cerca de 160 watts. No entanto, consideramos que o requisito de energia no modo inativo é um ponto de crítica. É notável como o sistema consome constantemente entre 30 e 50 watts da tomada sem nenhuma carga computacional - um nível de consumo de energia que nem mesmo muitos notebooks de última geração para jogos atingem quando estão ociosos.

Há alguma presença audível do dispositivo, mas ela permanece dentro de parâmetros aceitáveis. Medimos um nível de ruído contínuo da ventoinha de 30 dB(A) quando a unidade estava ociosa e 40 dB(A) quando a carga era de 100% durante nosso teste de estresse. Do ponto de vista térmico, a HP tem a dissipação de calor sob controle, embora o pequeno chassi fique visivelmente quente. Medimos temperaturas de superfície de cerca de 50 °C. É nesse ponto que a escolha dos materiais se mostra vantajosa, pois o chassi de plástico ainda pode ser manuseado sem problemas, mesmo nessas temperaturas, e não parece desagradavelmente quente ao toque.

Transparência

A seleção dos dispositivos a serem analisados é feita pela nossa equipe editorial. A amostra de teste foi fornecida ao autor como empréstimo pelo fabricante ou varejista para fins desta revisão. O credor não teve influência nesta revisão, nem o fabricante recebeu uma cópia desta revisão antes da publicação. Não houve obrigação de publicar esta revisão. Como empresa de mídia independente, a Notebookcheck não está sujeita à autoridade de fabricantes, varejistas ou editores.

É assim que o Notebookcheck está testando

Todos os anos, o Notebookcheck analisa de forma independente centenas de laptops e smartphones usando procedimentos padronizados para garantir que todos os resultados sejam comparáveis. Desenvolvemos continuamente nossos métodos de teste há cerca de 20 anos e definimos padrões da indústria no processo. Em nossos laboratórios de teste, equipamentos de medição de alta qualidade são utilizados por técnicos e editores experientes. Esses testes envolvem um processo de validação em vários estágios. Nosso complexo sistema de classificação é baseado em centenas de medições e benchmarks bem fundamentados, o que mantém a objetividade.