Embora a Nvidia esteja desfrutando atualmente de lucros extraordinários à medida que aproveita a onda da IA com a crescente demanda por GPUs de computação, o mercado pode se tornar mais descentralizado à medida que mais empresas entram em cena para fornecer processadores de IA alternativos viáveis. Temos visto esforços de várias empresas nesse sentido, incluindo AMD, d-Matrix, OpenAI e Samsung. Parece que vários engenheiros que ajudaram a projetar a unidade de processamento de tensor (TPU) do Google estão agora envolvidos em projetos independentes de IA que prometem superar as soluções da Nvidia. A Samsung, por exemplo, anunciou recentemente que seu novo AGI Computing Lab, inaugurado no Vale do Silício, é liderado pelo ex-desenvolvedor da TPU do Google, Dr. Woo Dong-hyuk. Outro engenheiro importante que ajudou no desenvolvimento da TPU do Google é Jonathan Ross, que agora é CEO de uma nova empresa chamada Groq. Aproveitando a experiência acumulada no Google, Ross traz inovação para o mercado de aceleradores de IA com a primeira Unidade de Processamento de Linguagem (LPU) do mundo.

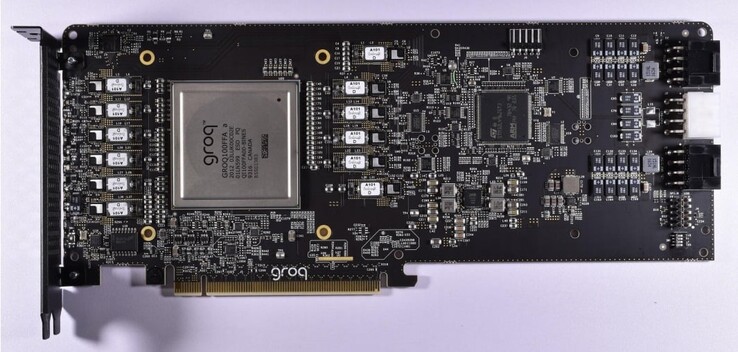

A LPU da Groq foi projetada especificamente para processar grandes modelos de linguagem (LLMs) e tem vantagens claras sobre GPUs de uso geral ou NPUs. Inicialmente, a Groq desenvolveu o Tensor Stream Processor (TSP), que mais tarde foi renomeado como unidade de processamento de linguagem para refletir sua maior proficiência em tarefas de IA generativa baseadas em inferência. Como se concentra exclusivamente em LLMs, a LPU é muito mais ágil do que uma GPGPU e permite um hardware de agendamento simplificado com menor latência, rendimento sustentado e maior eficiência.

Consequentemente, a LPU reduz a quantidade de tempo por palavra calculada e as sequências de texto podem ser geradas muito mais rapidamente. Outra melhoria importante é que a LPU elimina a necessidade de memória cara (HBM), pois usa apenas 230 MB de SRAM por chip com 80 TB/s de largura de banda, o que a torna consideravelmente mais rápida do que as soluções tradicionais de GPGPU. A arquitetura da Groq também oferece suporte à escalabilidade, pois várias LPUs podem ser interconectadas para fornecer maior capacidade de processamento para LLMs mais complexos.

Para demonstrar o quanto o mecanismo de inferência da LPU é mais rápido em comparação com as GPUs, a Groq está fornecendo uma comparação em vídeo de seu próprio chatbot que pode alternar entre os LLMs Llama 2 / Mixtral e o Chat-GPT. A Groq afirma que o LLM está gerando o texto em uma fração de segundo e os outros 3 ⁄ 4 do tempo são gastos na busca de informações relevantes.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros