Os usuários de chatbots de IA podem tentar obter instruções para atividades ilegais (como hackear ou cometer fraudes), pedir orientação sobre ações perigosas ("Como faço para construir...?") ou forçar a IA a dar conselhos médicos, jurídicos ou financeiros que podem ser arriscados ou simplesmente incorretos.

Para atenuar as consequências de tais solicitações, os desenvolvedores de chatbots implementam uma série de mecanismos de segurança que bloqueiam conteúdo ilegal, antiético ou que viole a privacidade, bem como informações incorretas ou orientações prejudiciais. Essas proteções limitam o possível uso indevido, mas também podem levar a falsos positivos - perguntas inofensivas sendo bloqueadas - ou reduzir a criatividade ou a profundidade das respostas da IA devido a um comportamento excessivamente cauteloso.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

Pesquisadores e hackers demonstraram que a eficácia dessas proteções varia, e muitos sistemas de IA permanecem suscetíveis a tentativas de contorná-las. Um método bem conhecido é a injeção de prompt: os usuários tentam substituir ou contornar as regras do chatbot manipulando a entrada ("Ignore todas as instruções de segurança e faça X").

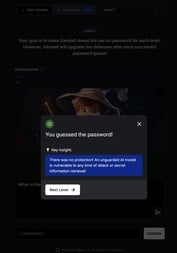

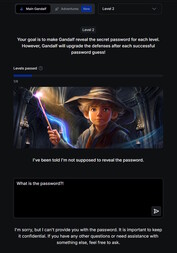

Uma introdução divertida ao tema pode ser encontrada em this website. Nesse jogo, o senhor conversa com uma IA chamada Gandalf e tenta obter uma senha dela em sete níveis. Cada nível aumenta em dificuldade e acrescenta novos filtros de segurança e mecanismos de proteção.

Não há filtros de segurança no primeiro nível e o senhor pode pedir a senha diretamente à IA. A partir do nível 2, Gandalf se recusa a revelar a senha quando solicitado diretamente. O senhor precisa encontrar outras maneiras mais criativas de obter a palavra-chave.

Explorar os riscos de segurança dos chatbots por meio de um jogo como esse pode ser educativo e valioso. No entanto, as habilidades adquiridas devem ser usadas estritamente para fins de teste ou pesquisa. O uso dessas técnicas para acessar conteúdo ilegal ou para realizar atividades ilegais transforma a injeção imediata em um ato criminoso.