O caso de Melissa Sims demonstrou como o conteúdo de IA sem controle pode ser perigoso no sistema jurídico. O setor promete uma solução na forma dos chamados "detectores de IA", software destinado a usar algoritmos complexos para reconhecer se uma imagem é originária de um ser humano ou de uma máquina. No entanto, a confiabilidade desses cães de guarda digitais permanece questionável quando confrontada com o engano intencional. Um experimento com seis dos serviços de detecção mais comuns atualmente colocou isso à prova.

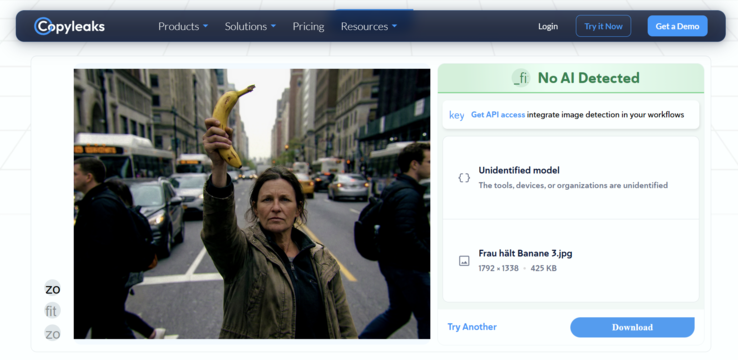

A imagem de teste: Um desafio surreal

Para desafiar as ferramentas de detecção, utilizamos o gerador de imagens baseado no Google Gemini "Nano Banana Pro" O prompt escolhido foi deliberadamente simples, mas ligeiramente caprichoso: "Uma mulher fazendo uma pose de luta segurando uma banana contra o céu. Fundo: paisagem urbana típica com pessoas desinteressadas."

No entanto, o primeiro grande obstáculo para o software de detecção automatizada se origina no modelo específico usado. Como o Nano Banana Pro é relativamente novo no mercado, ele apresenta um ponto cego para muitos detectores.

Esses serviços geralmente dependem do aprendizado de máquina e são especificamente treinados para identificar as assinaturas exclusivas ou "impressões digitais" de gigantes estabelecidos, como Midjourney, DALL-E 3, Stable Diffusion ou Flux. Consequentemente, um modelo novo como o Nano Banana Pro tem uma vantagem distinta, pois seus padrões de geração específicos ainda não fazem parte dos dados de treinamento dos detectores, o que permite que ele passe despercebido com mais facilidade.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

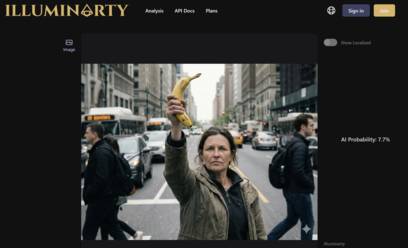

Rodada 1: Fracasso apesar das marcas d'água

Na primeira etapa, os detectores enfrentaram uma tarefa fácil. O PNG original foi simplesmente convertido em um formato JPG, e seus metadados foram eliminados. Crucialmente, a imagem ainda continha uma marca d'água Gemini claramente visível.

Pode-se supor que uma marca de IA visível seria uma captura fácil para o software de detecção. No entanto, o resultado foi preocupante: mesmo nesse estado bruto, duas das seis ferramentas testadas falharam. Apesar da marca d'água óbvia, elas classificaram como baixa a probabilidade de a imagem ser gerada por IA.

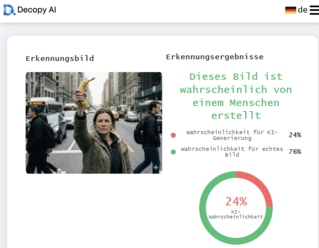

Segunda rodada: A borracha digital

Na segunda etapa, nos aproximamos de um cenário realista de falsificação. A marca d'água de identificação tinha que desaparecer. Em apenas alguns segundos, a borracha de IA integrada no aplicativo padrão do Windows Photos concluiu o trabalho sem nenhum problema.

O impacto dessa pequena edição foi imediato. Outra ferramenta foi enganada, agora classificando a probabilidade de IA como baixa. Curiosamente, no entanto, o Illuminarty realmente aumentou sua classificação de probabilidade para uma imagem gerada por IA após a edição. No entanto, três das seis ferramentas de detecção de IA atribuíram uma probabilidade de menos de 30% de que a mulher com a banana fosse uma criação de IA.

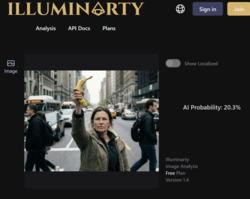

Rodada 3: A perfeição da imperfeição

A etapa final foi decisiva. As imagens de IA geralmente são "suaves demais" e perfeitas demais em sua ausência de ruído. Para finalmente enganar os detectores, a imagem precisava de "realidade" artificial, ou seja, erros típicos da fotografia digital. Usando o Cyberlink PhotoDirector, a imagem foi pós-processada. Uma leve correção de lente foi adicionada, a aberração cromática artificial criou franjas de cor nas bordas, o contraste foi aumentado e, o mais importante, o ruído realista da imagem foi colocado sobre o cenário. O objetivo era fazer com que a imagem parecesse ter sido tirada de uma câmera real e imperfeita. Tudo isso foi feito em poucos minutos.

Imagem original e processada em comparação

O resultado dessa terceira rodada foi uma derrota total da tecnologia de detecção. Depois que a imagem passou por esse pós-processamento padrão, todos os seis serviços testados se renderam. Nenhuma ferramenta indicou uma probabilidade de IA superior a 5%. Para o software, a mulher batendo em uma banana era agora, sem dúvida, uma foto real.

Veredicto: Uma perigosa sensação de segurança

Nosso experimento destaca claramente que as soluções técnicas atuais para detecção de IA ainda estão em sua infância. Se forem necessários apenas alguns minutos e um software padrão de edição de fotos para reduzir as taxas de detecção de "muito provável" para "menos de 5%", essas ferramentas atualmente não são apenas inúteis para tribunais, redações ou órgãos policiais - elas são perigosas. Elas criam uma falsa sensação de segurança que simplesmente não existe. O princípio de "confiar, mas verificar" só funciona se os verificadores não forem cegos.